Hadoop平台安装与配置

一、创建三台虚拟机

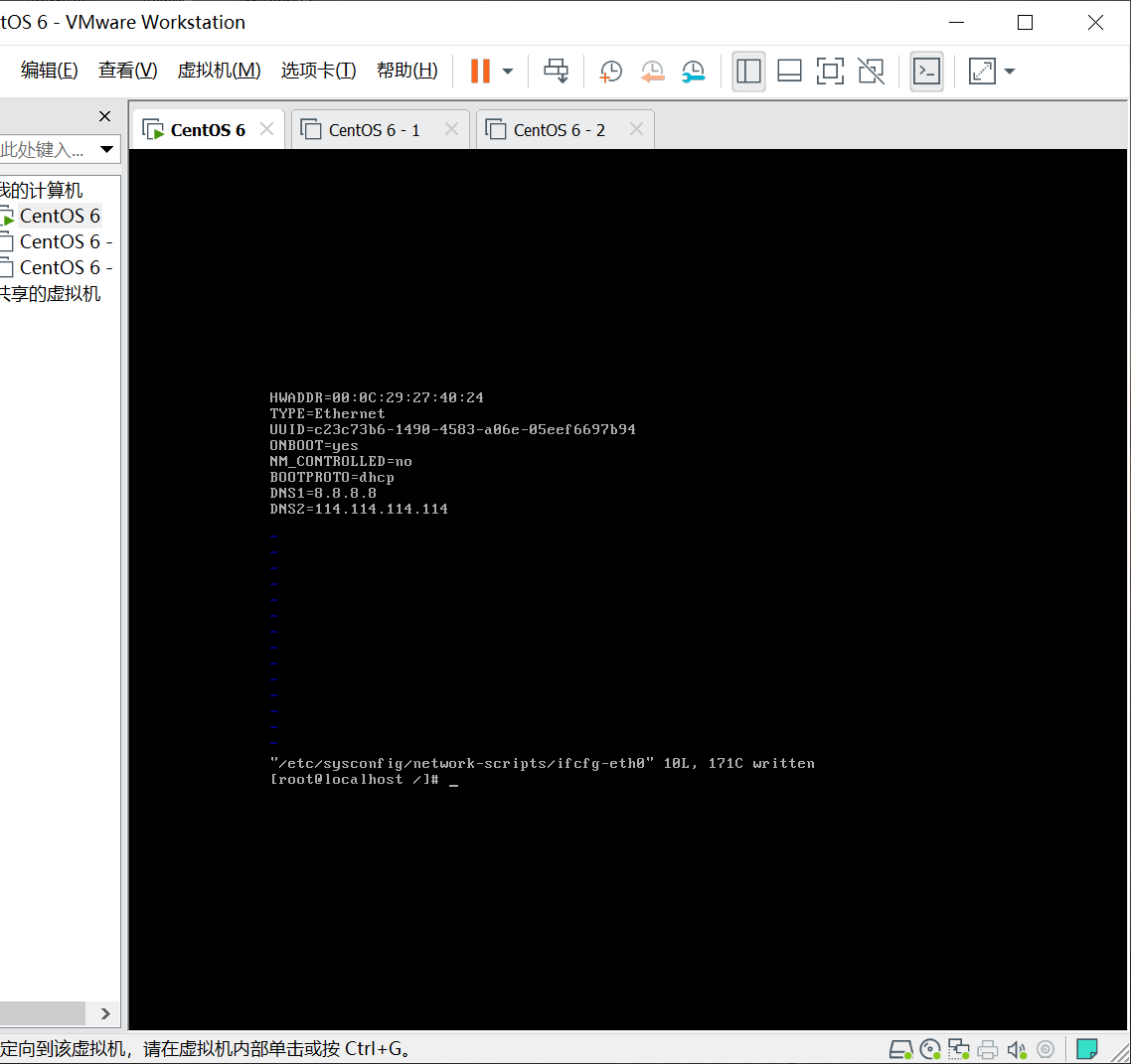

1、 为创建好的虚拟机配置网络

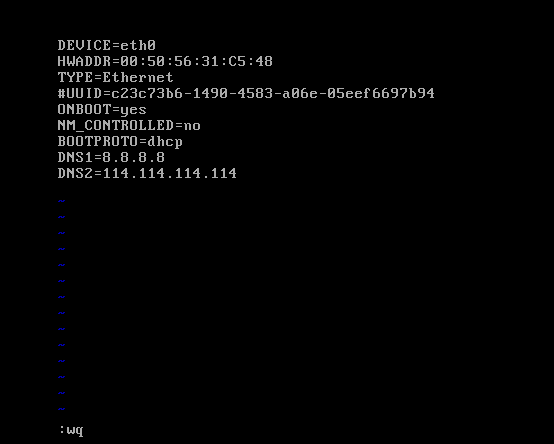

使用命令 vi /etc/sysconfig/network-scripts/ifcfg-eth0

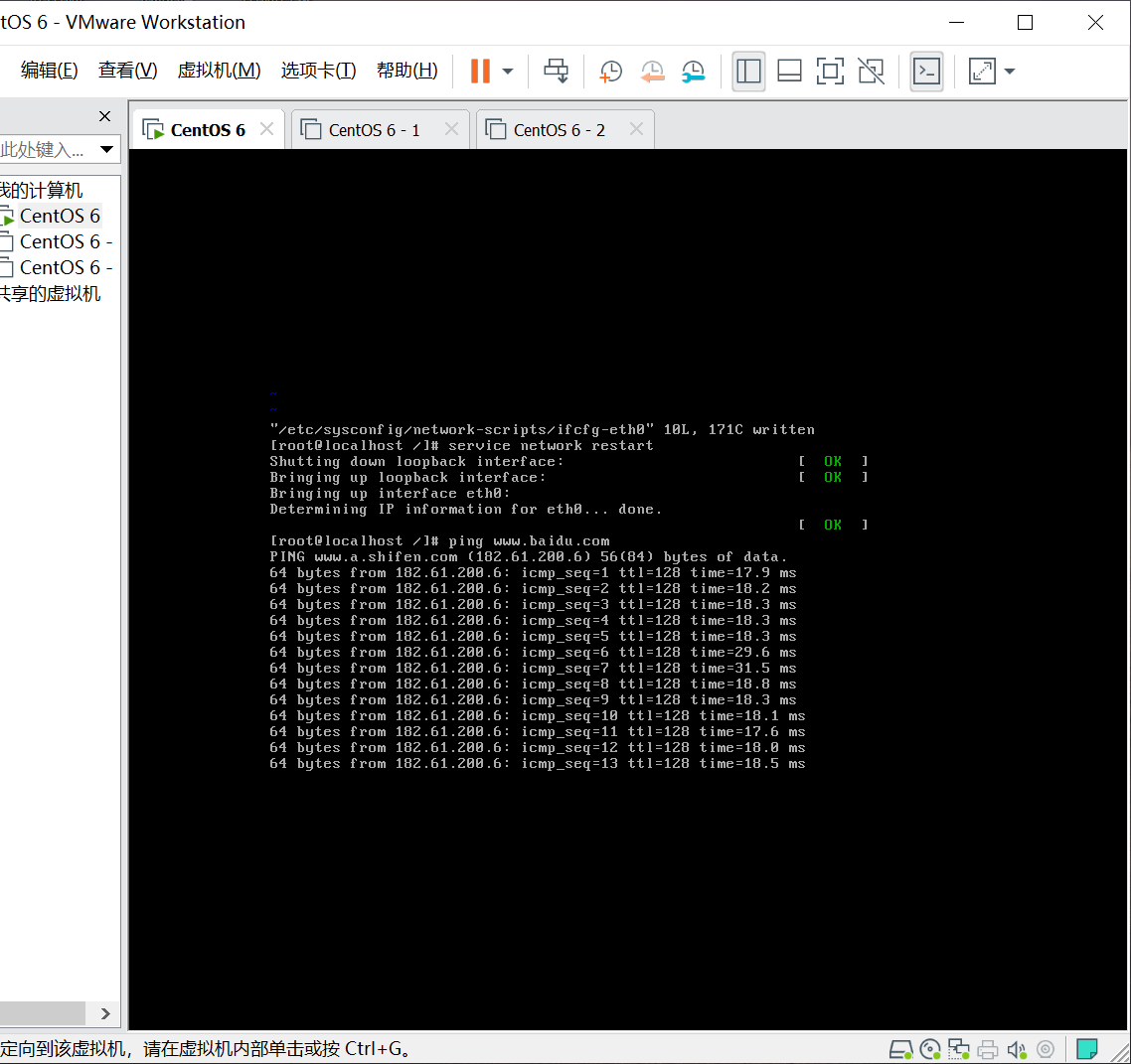

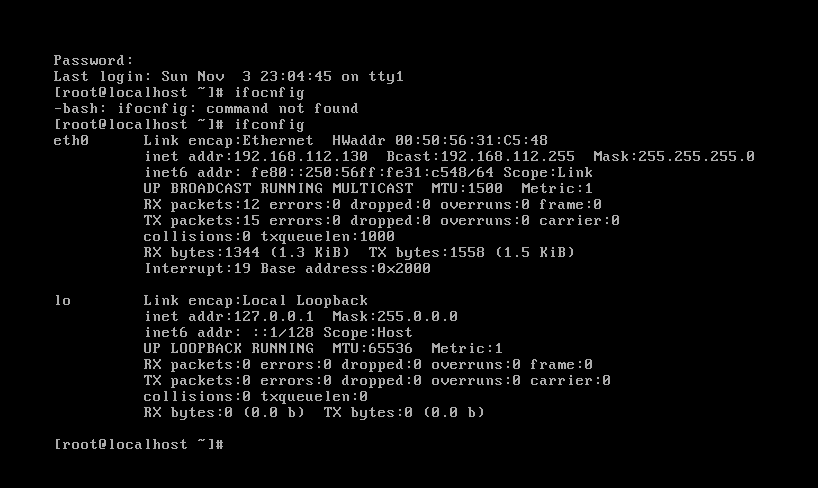

重启服务,并验证配置好的网络

2、 使用模板创建另外两台虚拟机

使用实验一中创建的CentOS 6虚拟机,并使用OVF模板创建另外两台虚拟机

二、配置网络

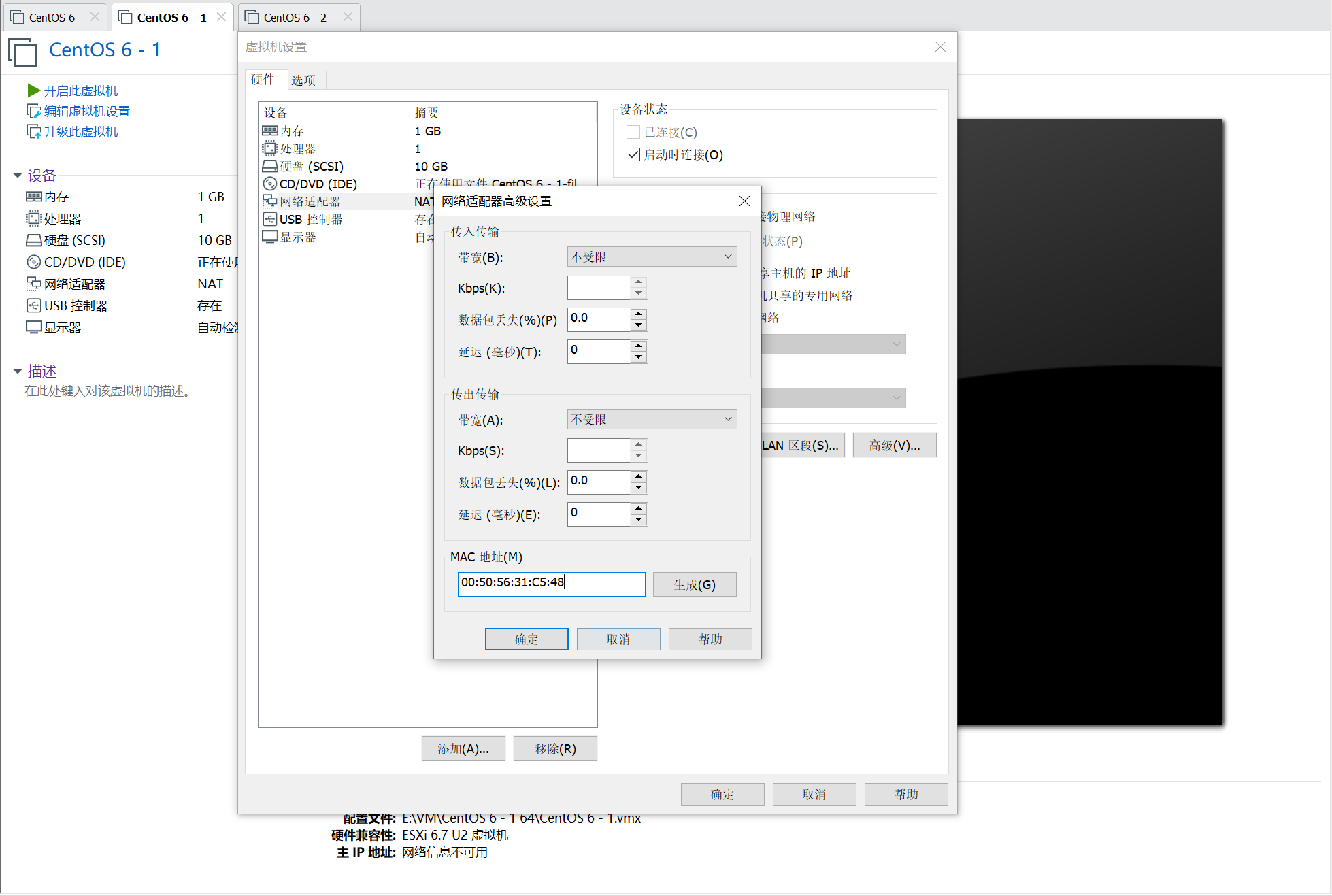

1、 生成MAC地址

由于直接使用OVF模板创建了虚拟机,所以需要为两台模板虚拟机生成MAC地址

2、 修改MAC地址

使用命令 vi /etc/sysconfig/network-scripts/ifcfg-eth0

删除旧网卡规则映射

使用命令 rm /etc/udev/rules.d/70-persistent-net.rules

删除后重启机器

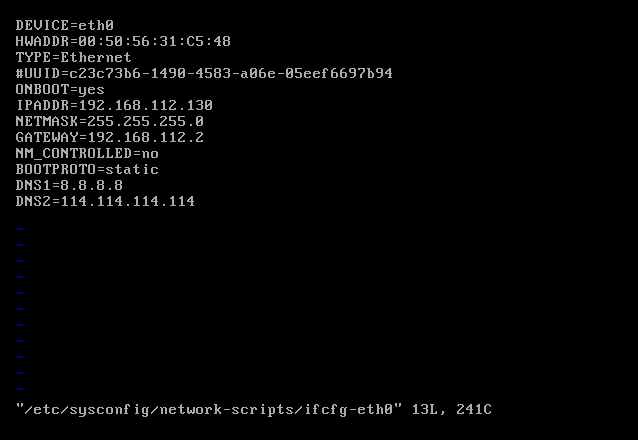

3、 修改ip、子网掩码、网关

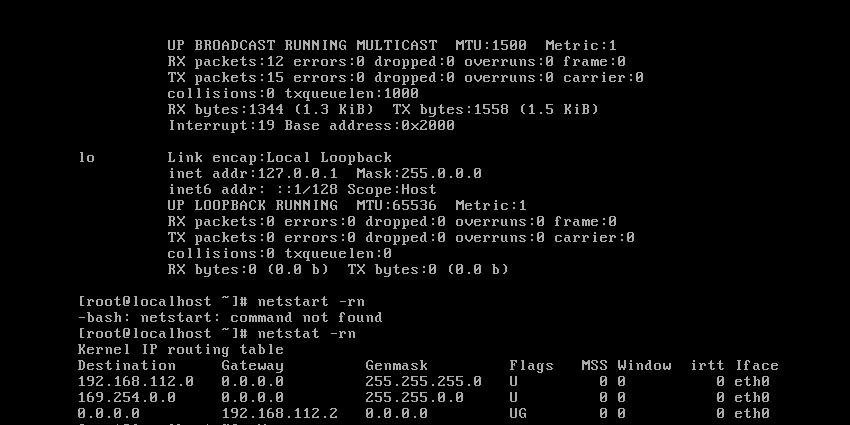

使用命令 ifconfig 、 netstat -rn 查看ip、子网掩码、网关地址

修改ip、子网掩码、网关,在网卡配置中增加 IPADDR、NETMASK、GATEWAY

4、重启服务,关闭防火墙

1 | service network restart |

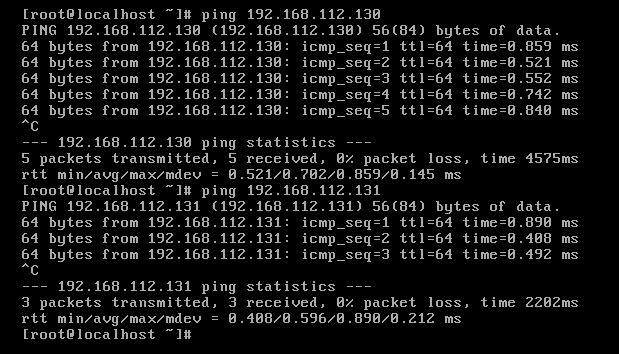

5、 测试网络

三个虚拟机ip:

1 | CentOS 6 : 192.168.112.129 |

测试网络:

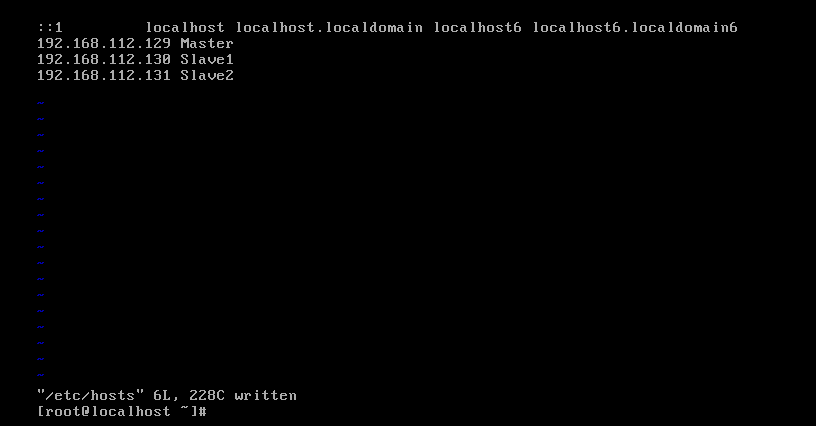

三、修改hosts

1、分别修改虚拟机hosts文件

使用命令 vi /etc/hosts

四、配置SSH免登录

1、ssh-keygen

使用命令 ssh-kengen

2、配置两两间的免登录

1 | ssh-copy-id -i .ssh/id_rsa.pub root@Slave1 |

五、安装Hadoop平台

1、安装java

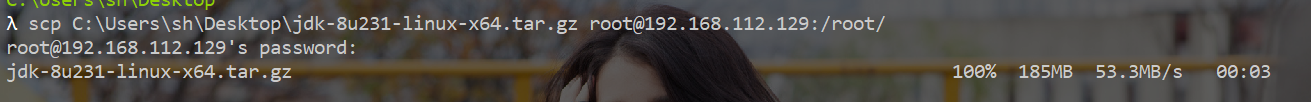

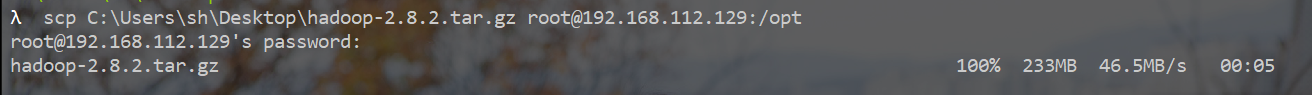

2、将下载的java安装包传入虚拟机

3、解压

1 | tar -zxvf jdk-8u231-linux-x64.tar.gz |

4、添加环境变量

vi /etc/profile

1 | export JAVA_HOME=/opt/jdk |

5、安装Hadoop

网址: https://archive.apache.org/dist/hadoop/core/hadoop-2.8.2/

解压后添加环境变量,修改 .bashrc 添加

1 | export HADOOP_HOME=/opt/hadoop |

修改 hadoop-env.sh 和 yarn-env.sh

1 | export JAVA_HOME=/opt/jdk |

修改 slaves ,添加Slave1、Slave2

修改 core-site.xml

1 | <configuration> |

修改 hdfs-site.xml , 设置副本数、心跳间隔

1 | <configuration> |

修改 mapred-site.xml

1 | <configuration> |

修改 yarn-site.xml

1 | <configuration> |

格式化文件系统

hdfs namenode -format

启动Hadoop

start-all.sh

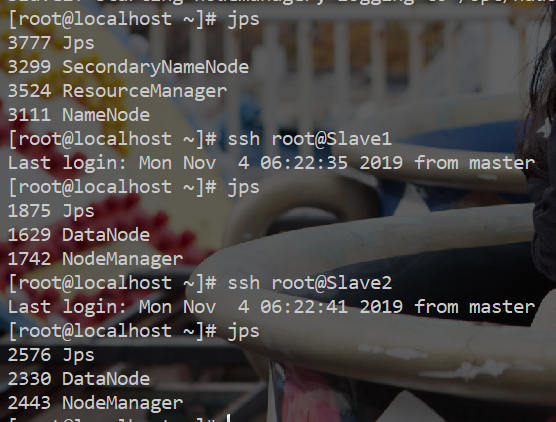

查看jps